Cet article explique de façon simple l’empreinte environnementale d’une requête d’IA (texte) et ce que ces chiffres représentent concrètement. Les valeurs citées correspondent à une réponse d’environ 400 tokens (≈ 1 page de texte, soit ~400–500 mots).

Un chiffre à retenir : une tasse de café (ordre de grandeur) représente environ quelques centaines de requêtes IA, selon l’hypothèse utilisée — les calculs détaillés sont fournis en annexe.

Résultats clés (par requête médiane / réponse d’une page) :

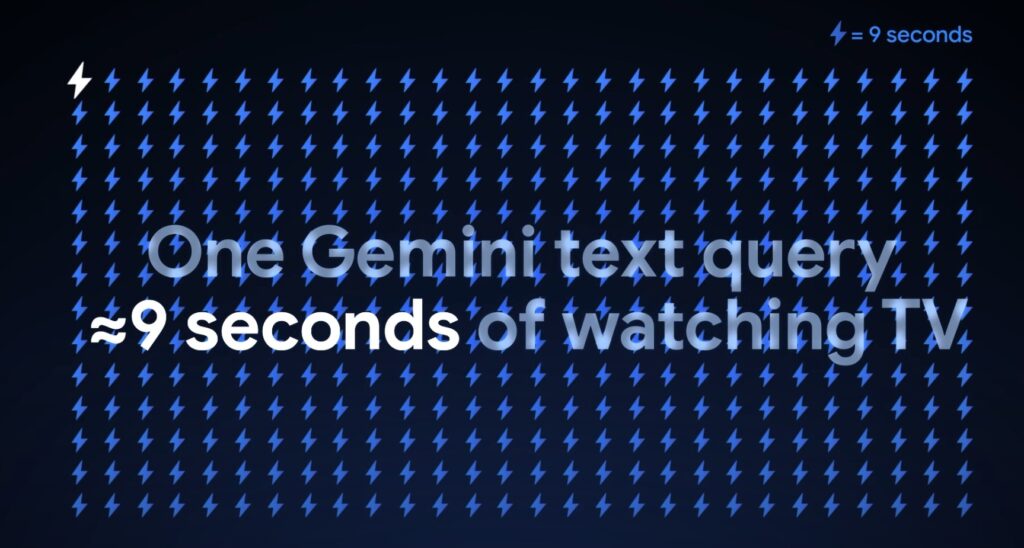

- Google Gemini : 0,24 Wh d’énergie • 0,03 gCO₂e • 0,26 mL d’eau (≈ 5 gouttes).

- ChatGPT (estimation publique) : ≈ 0,34 Wh d’énergie.

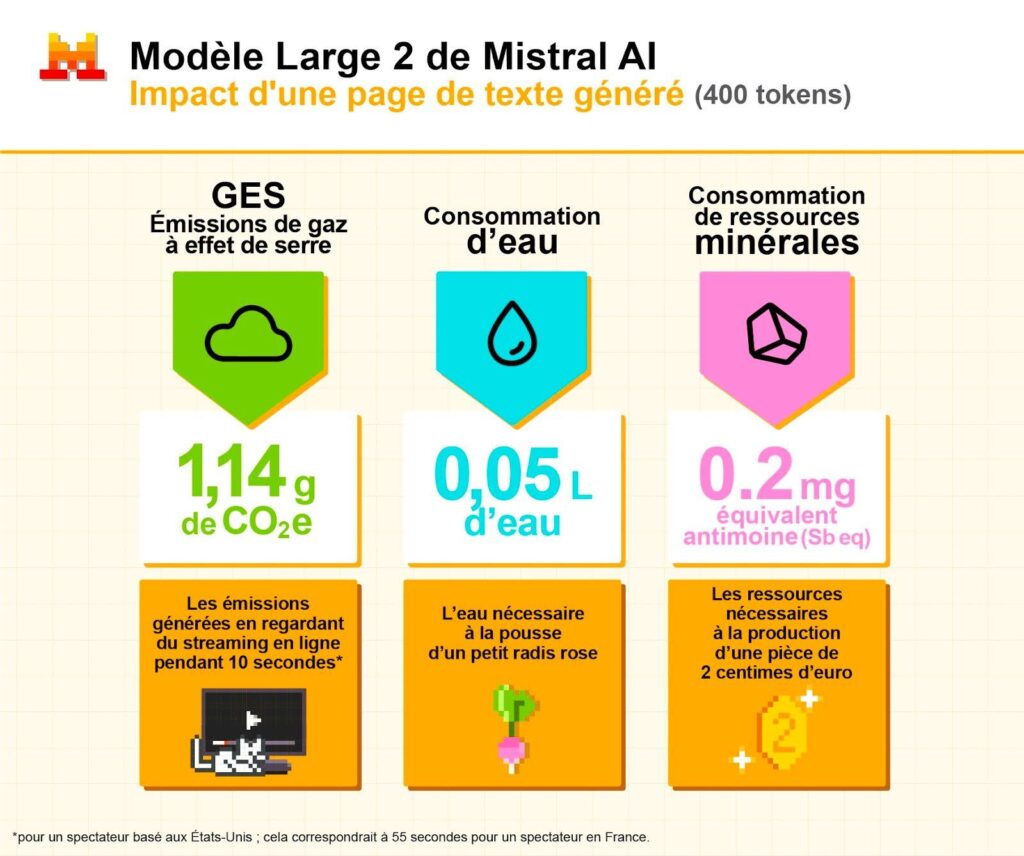

- Mistral Large 2 : 1,14 gCO₂e • 45 mL d’eau.

Pour mettre ces nombres en perspective : 0,24 Wh, c’est l’équivalent d’à peine quelques secondes de télévision ; 0,26 mL d’eau, c’est ≈ 5 gouttes. Autrement dit, une requête individuelle a un impact très faible. Mais attention : l’impact total d’un modèle inclut aussi son entraînement — et là les ordres de grandeur montent fortement.

Pourquoi les chiffres varient

Différentes entreprises publient des chiffres différents parce qu’elles ne mesurent pas exactement la même chose et, bien sûr, n’ont pas les mêmes performances ni la même consommation. Certains rapports mesurent l’empreinte à l’échelle opérationnelle (énergie utilisée dans les data centers, surprovisionnement pour la disponibilité, PUE, CPU/RAM, refroidissement, etc.). D’autres font une analyse de cycle de vie (ACV) plus large qui intègre la fabrication des serveurs, la consommation d’eau en amont, et d’autres impacts liés à la chaîne de production.

Les écarts viennent aussi des hypothèses : quel mix électrique est utilisé pour convertir des Wh en gCO₂ ? Est‑ce qu’on inclut l’énergie des appareils utilisateurs (smartphone, PC) ? Est‑ce qu’on compte le trafic réseau ? Toutes ces décisions méthodologiques modifient fortement les résultats.

Il faut donc prendre ces chiffres avec précaution : on peut faire dire beaucoup de choses aux nombres si on cache les hypothèses. En même temps, il faut saluer la transparence : Google et Mistral ont mis à disposition données et méthodes, ce qui permet aux chercheurs et au public de comparer et d’améliorer les protocoles.

L’eau : pourquoi on en parle pour l’IA

Les data centers utilisent souvent de l’eau (parfois perdue) pour le refroidissement. Quand une entreprise publie une valeur par requête (ex. 0,26 mL ou 45 mL), elle indique la part d’eau moyenne nécessaire au refroidissement et à l’infrastructure pour fournir cette réponse, proportionnelle à l’énergie consommée.

Comparaisons utiles :

- Google : 0,26 mL ≈ 5 gouttes d’eau (hypothèse 1 mL ≈ 20 gouttes).

- Mistral : 45 mL ≈ 9 cuillères à café (1 cuillère ≈ 5 mL).

Pour donner encore plus de perspective, préparer une tasse de café implique typiquement 150–200 mL d’eau (quantité d’eau utilisée pour l’infusion). Ainsi :

- 1 tasse (150 mL) ≈ 577 requêtes Gemini (150 ÷ 0,26).

- 1 tasse (150 mL) ≈ 3 requêtes Mistral (150 ÷ 45).

Autrement dit, sur l’axe de l’eau, une requête Mistral (45 mL) utilise une quantité d’eau comparable à presque un tiers d’une tasse de café, tandis qu’une requête Gemini (0,26 mL) n’est que quelques gouttes.

Ces quantités restent faibles pour une seule requête, mais multipliées par des millions d’appels par jour, la consommation peut devenir significative, surtout dans des zones sous stress hydrique.

Il existe des technologies de refroidissement qui n’utilisent pas d’eau perdue (ex : refroidissement à air, cycles fermés), mais leur déploiement dépend du climat, du coût et des choix d’ingénierie locaux.

L’énergie : comment la mesurer et pourquoi l’échelle compte

L’énergie par requête est souvent donnée en watt-heures (Wh). Une petite consommation par requête devient négligeable pour un utilisateur isolé. En revanche, à l’échelle d’une plateforme qui sert des milliards de requêtes, la somme devient importante.

Comparaisons d’énergie (résultats) :

- Google Gemini (0,24 Wh par requête) : équivaut à ≈ 8,6 secondes d’utilisation d’une télévision ou d’un ordinateur portable à 100 W, ou ≈ 4,8 minutes d’utilisation d’un téléphone mobile à 3 W.

- ChatGPT (≈ 0,34 Wh par requête) : équivaut à ≈ 12,2 secondes d’utilisation d’une télévision ou d’un ordinateur portable à 100 W, ou ≈ 6,8 minutes d’utilisation d’un téléphone mobile à 3 W.

Comparaison avec une tasse de café (énergie) — hypothèses :

- Hypothèse basse : 1 tasse de café = 25 Wh (méthode économique : eau chauffée au micro‑ondes ou bouilloire efficace et petit volume).

- Hypothèse haute : 1 tasse de café = 50 Wh (méthode plus gourmande : cafetière filtre, temps de chauffe plus long, pertes énergétiques).

Équivalences selon hypothèses :

- Avec 25 Wh :

- 1 tasse = ≈ 104 requêtes Gemini (25 ÷ 0,24).

- 1 tasse = ≈ 74 requêtes ChatGPT (25 ÷ 0,34).

- Avec 50 Wh :

- 1 tasse = ≈ 208 requêtes Gemini (50 ÷ 0,24).

- 1 tasse = ≈ 147 requêtes ChatGPT (50 ÷ 0,34).

Remarque : l’étude de Mistral ne fournit pas explicitement de valeur Wh d’inférence dans ses communiqués publics, nous n’avons donc pas converti son chiffre de CO₂ en Wh ici afin de rester rigoureux.

Ces équivalences donnent une perspective immédiate : une requête prise isolément correspond à quelques secondes d’écran, quelques minutes d’utilisation d’un téléphone, ou à une petite fraction d’énergie comparée à la préparation d’une tasse de café. Multipliée à grande échelle, l’addition devient notable.

Points à retenir :

- L’efficacité matérielle (puces dédiées) et logicielle (algorithmes, batching, distillation) réduit fortement l’énergie par requête.

- L’échelle joue : Google, avec ses centres optimisés et son matériel maison, obtient souvent des chiffres par requête plus faibles que des acteurs plus petits.

Le CO₂ : petit par requête, énorme à l’entraînement

Les émissions par requête peuvent paraître négligeables (fractions de gramme). Concrètement, les chiffres publiés donnent environ 0,03 gCO₂e par requête pour Google Gemini et ≈ 1,14 gCO₂e pour une réponse longue de Mistral (≈ 400 tokens).

Pour rendre ces valeurs parlantes :

- Conversion par rapport à une tasse de café (10 gCO₂e/tasse, hypothèse) :

- 1 tasse (10 gCO₂e) = ≈ 333 requêtes Gemini (10 ÷ 0,03).

- 1 tasse (10 gCO₂e) = ≈ 9 requêtes Mistral (10 ÷ 1,14).

- Conversion par rapport à la voiture (120 gCO₂/km, hypothèse voiture moyenne) :

- 1 km voiture = 120 gCO₂ → = ≈ 4 000 requêtes Gemini (120 ÷ 0,03).

- 1 km voiture = 120 gCO₂ → = ≈ 105 requêtes Mistral (120 ÷ 1,14).

Amortissement d’un entraînement (exemple Mistral) :

- Mistral indique 20,4 ktCO₂e pour l’entraînement d’un modèle majeur = 20 400 tonnes CO₂ = 20 400 000 kg = 20 400 000 000 g.

- En années-voiture : si l’on prend une voiture moyenne émettant ≈ 1,44 tCO₂/an (12 000 km × 120 g/km), alors 20,4 ktCO₂ ≈ ≈ 14 167 années-voiture — autrement dit les émissions annuelles d’environ 14 000 voitures roulant 12 000 km chacune.

- Pour donner une échelle urbaine, ces 20,4 ktCO₂ représentent environ 1,6 jours des émissions annuelles directes de la ville de Paris (les émissions directes de Paris étaient d’environ 4,72 MtCO₂ en 2022).

Ces ordres de grandeur montrent qu’un entraînement pèse très lourd et que son impact doit être mis en regard du nombre total de requêtes servies par la suite pour mesurer l’empreinte par utilisation.

Conseils pratiques pour utiliser l’IA de façon plus sobre

- Choisir un modèle adapté : privilégier les modèles légers quand la tâche est simple.

- Consolider les requêtes : regrouper les questions plutôt que multiplier les petits prompts.

- Limiter la longueur : moins de tokens générés = moins d’énergie consommée.

- Favoriser la transparence : utiliser des services qui publient leurs méthodes et indicateurs.

- Évaluer l’usage à l’échelle : pour une organisation, mesurer les requêtes totales par mois aide à décider d’un plan d’action (cache, modèles locaux, quotas).

/

Partagez :

Organisation numérique PC : Solutions pour DYS

Bienvenue dans le monde fascinant de l’organisation numérique, où chaque fichier trouve sa place et…